Meta представила Llama 4: ИИ говорит на 200 языках и считывает 48 изображений за раз

Meta представила новое поколение ИИ-моделей Llama 4, способных обрабатывать текст, изображения и видео. Новые версии Scout и Maverick доступны разработчикам на llama.com и Hugging Face, а в ближайшее время появятся в сервисах Meta AI, включая WhatsApp, Messenger и Instagram.

Главное отличие от предыдущих версий — объединённая обработка текста и изображений. Scout использует 17 млрд активных параметров (из 109 млрд) и может анализировать до 48 изображений одновременно. Модель работает даже на одной видеокарте NVIDIA H100, опережая Google Gemma 3 по скорости. Контекстное окно составляет 10 млн токенов — это эквивалентно 20 часам видео или 5000 страниц текста.

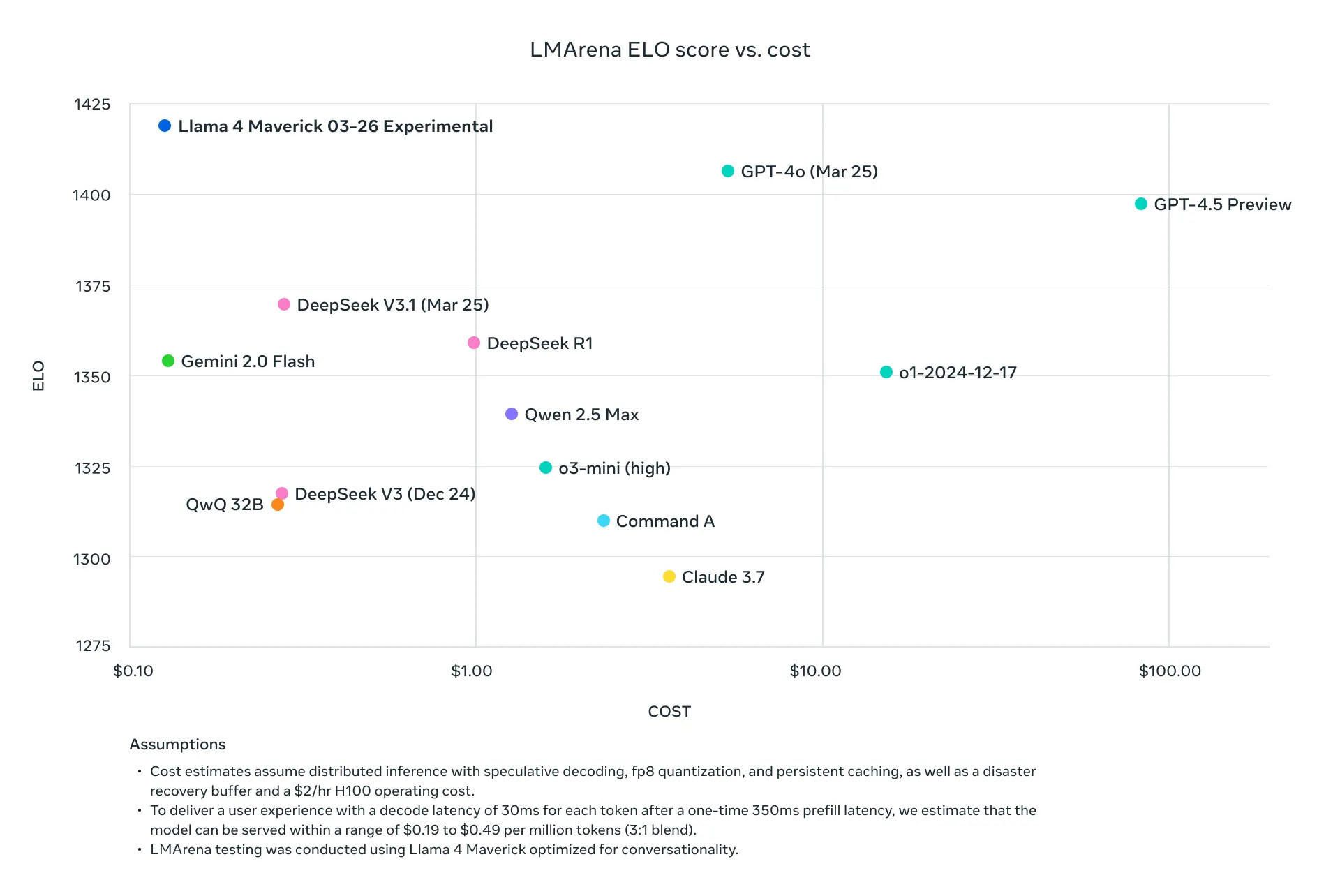

Модель Maverick с 400 млрд параметров (17 млрд активных) заняла 2-е место в рейтинге LMSYS Arena с 1417 баллами ELO. Она оптимизирована для серверов и подходит для генерации кода, логических задач и обработки больших объёмов текста. Для запуска достаточно одной DGX-ноды с 8 GPU H100.

Обе модели обучены на 30 трлн токенов, включающих данные на 200 языках. Безопасность обеспечивают инструменты Llama Guard и Prompt Guard. Частота отказов на спорные темы снижена до 2%. Обучение базовой модели Behemoth с 2 трлн параметров позволило ускорить разработку в 10 раз.

29 апреля на мероприятии LlamaCon корпорация Meta представит ИИ с логическим мышлением.